本文记录一下 Mac 本机安装 Hadoop 的过程,免得每次都要去搜索一堆博客才能安装成功。

环境

Mac:10.15.7

Hadoop:2.7.4

JDK:1.8.0_151

下载并解压

从官网下载解压到某个目录下,并在 /etc/profile 设置环境变量:

1 | export HADOOP_HOME=/usr/local/hadoop |

使环境变量生效:

1 | source /etc/profile |

查看是否安装成功:

1 | hadoop version |

修改 Hadoop 配置

修改 hadoop-env.sh 文件

1 | # 设置JAVA_HOME |

修改 core-site.xml 文件

1 | <property> |

修改 hdfs-site.xml 文件

1 | <property> |

修改 mapred-site.xml 文件

1 | <!-- 指定 mapreduce 运行在 yarn 上 --> |

修改 yarn-site.xml 文件

1 | <property> |

至此,需要修改和配置的文件就差不多了。

运行 Hadoop

格式化文件系统

1 | hdfs namenode -format |

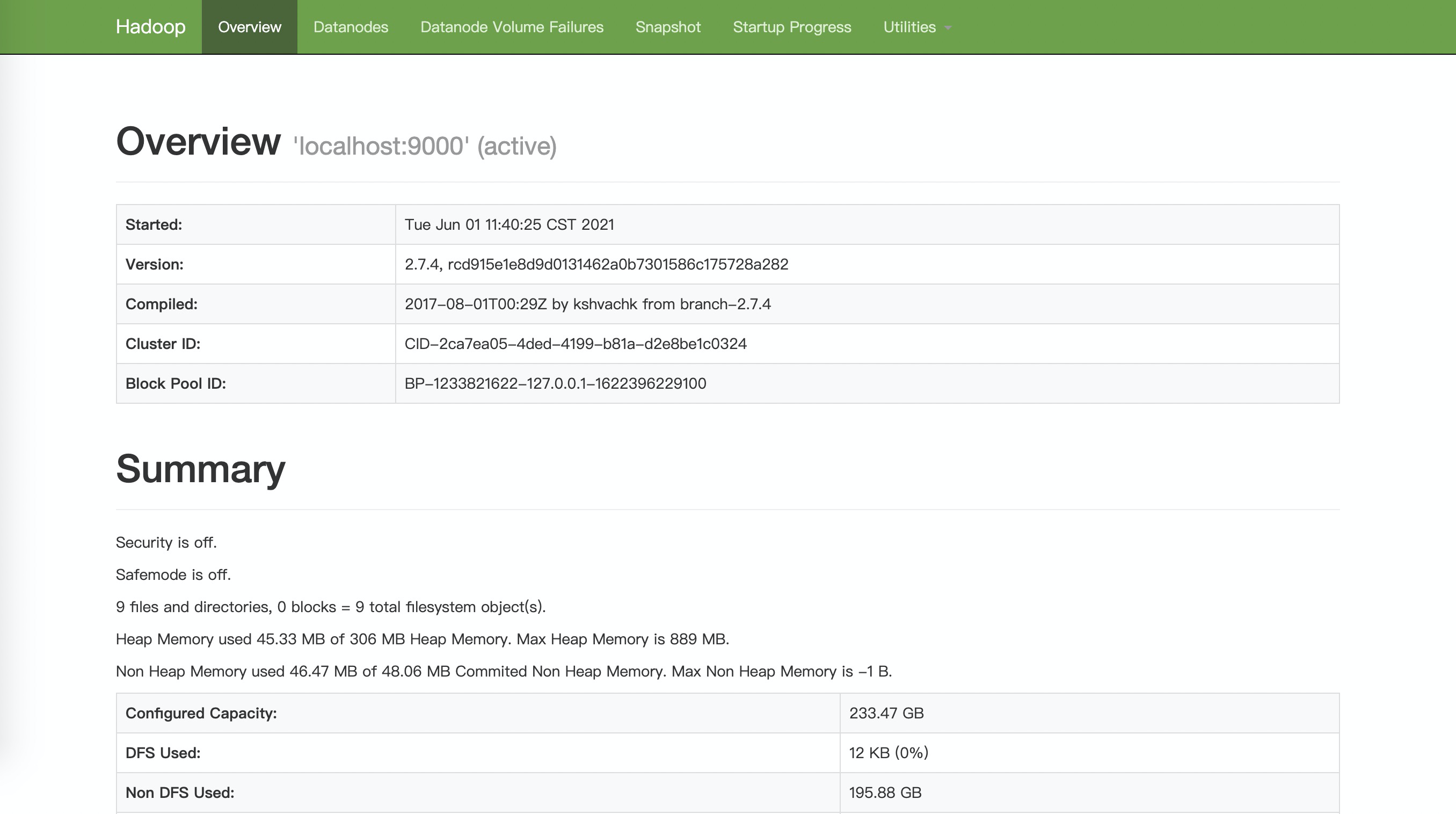

启动 NameNode 和 DataNode 服务

1 | HADOOP_HOME/sbin/start-dfs.sh |

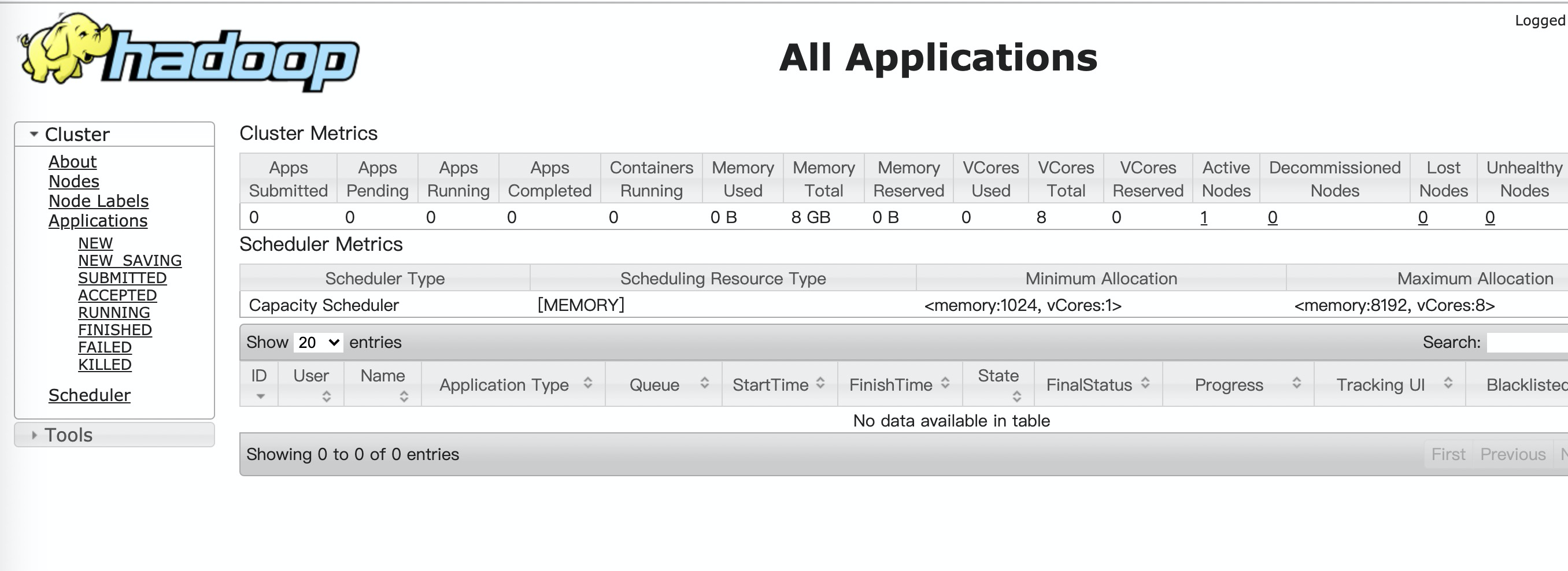

启动 Yarn

1 | HADOOP_HOME/sbin/start-yarn.sh |

一键启动

1 | HADOOP_HOME/sbin/start-all.sh |

查看相关进程

1 | jps |

遇到的问题

DataNode 启动失败

由于多次格式化导致 NameNode 和 DataNode 的 clusterID 不一致,修改为一致即可。

1 | cat /usr/local/hadoop/current/dfs/data/current/VERSION | grep 'clusterID' |